先日のDifyと同じくらいあっけなくLLMをローカルで動かせるのがOllamaです。

ローカルマシンにOllamaをインストールするのは以下のコマンド1行です。

curl -fsSL https://ollama.com/install.sh | shそして実行は次の1行。

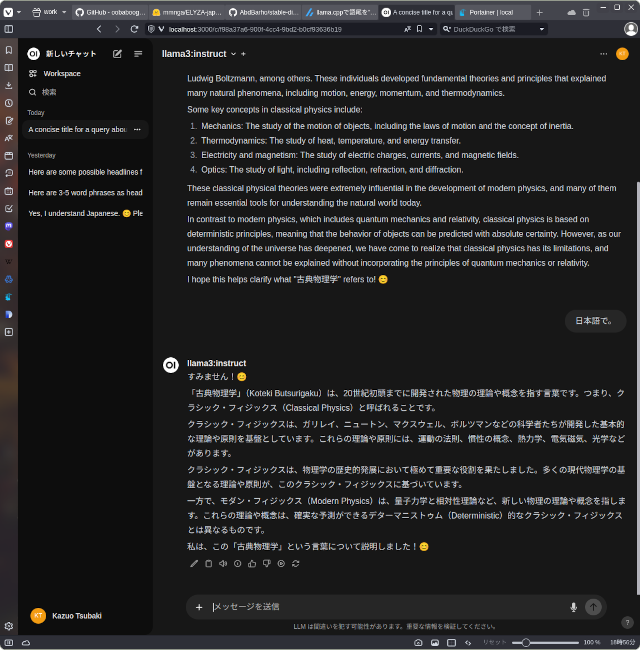

ollama run llama3これはモデルにLlama3を使ってアプリケーションを起動した例です。

Ollamaで使用できるモデルは公式ホームページのここに列挙されています。多くのモデルに対応しているので色々と試すのに良いですね。

これでもいんですがDockerでOpenWebUIと一緒に動かすのが好みです。

Dockerで実行するには次のコマンド1行です。

docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollamaGPU非搭載PCの場合は次のコマンドです。

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollamaollamaが言語モデルをプルできない問題が発生することがあります。その場合は、上記コマンドに

--network=hostを追加してみてください。

そしてOpenWebUIを動かします。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainこれでWebブラウザーから http://localhost:3000 を開けば使えます。適当なアカウントを登録して始めます。

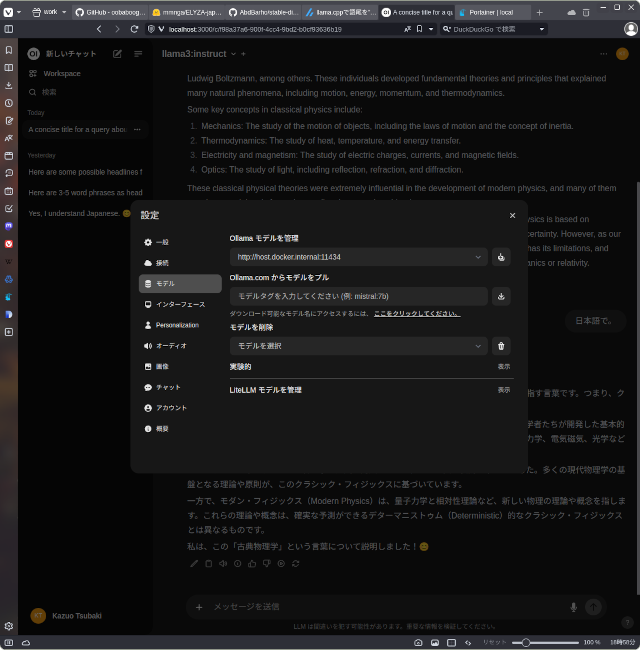

アカウントの設定メニューからモデルをダウンロードします。「Ollama.comからモデルをプル」と書かれているフィールドに「llama3」などを入力してフィールド右端のダウンロードボタンを押します。

今回はllama3:instructと入力してモデルをダウンロードして使いました。

「OllamaとOpenWebUIでLlama3」への2件のフィードバック