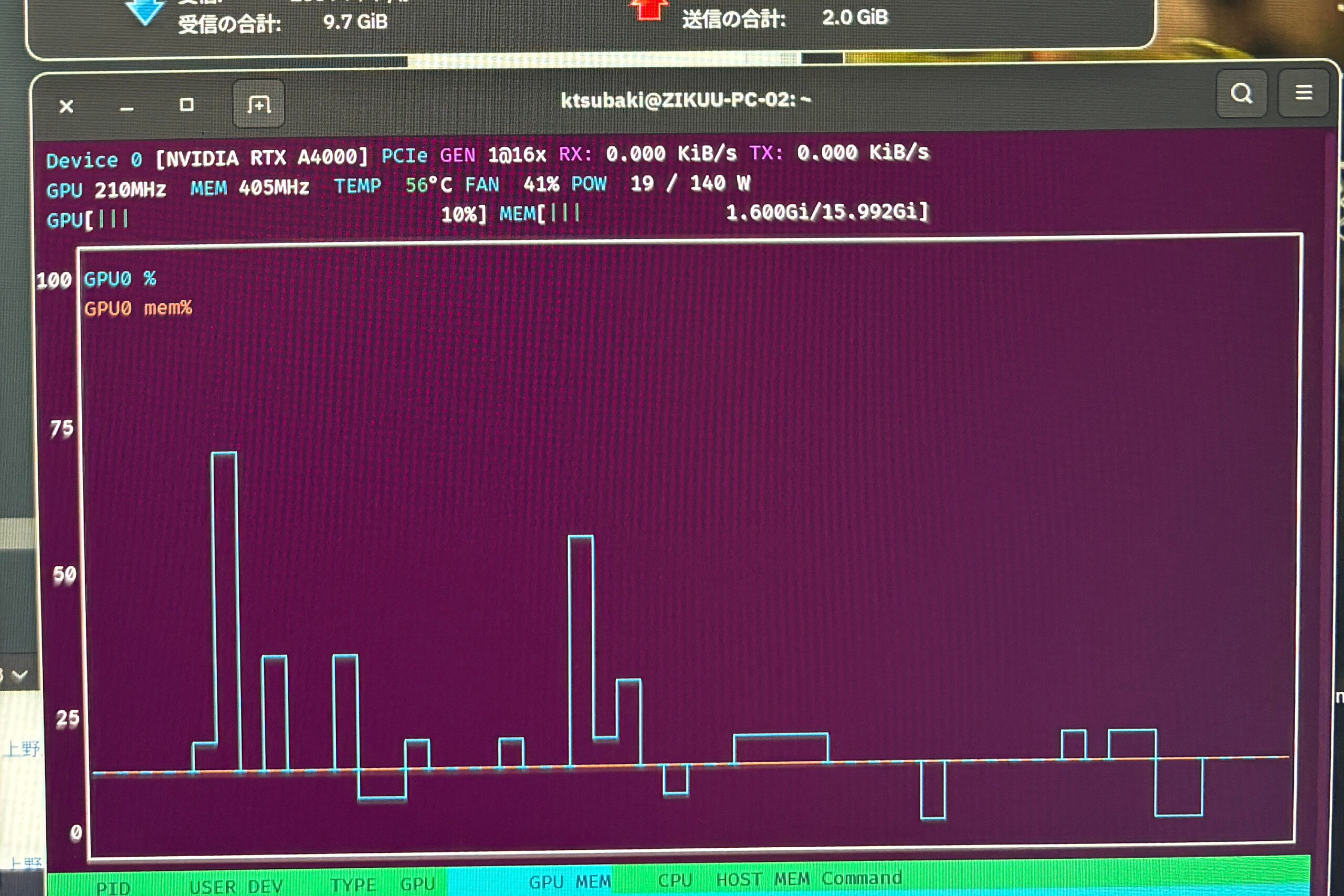

上の画像は先日小規模なLLMの学習をしている最中のGPUの状態をnvtopコマンドを実行して監視していたときのスクリーンショットです。

パラメーター数100万程度の小さなLLMですので、GPUの使用率は元々高くなく、VRAMは1GB程度しか使っていません。VRAMの使用量ばかり注視していて目が届かなかったのですが、画面上部にPCIEインターフェースの情報が表示されています。PCIE 1×16と出ています。このPCのマザーボードはPCIE 4の16レーンのインターフェースを持っていて、GPUのRTX A4000もPCIE 4の16レーンで接続されていますが、このような小さなモデルの学習ではPCIEインターフェースのフル性能を使用しないんですね。

安価で人気のGeForce RTX 3060はPCIE 4 x 16のインターフェースです。その後継機種のRTX 4060はPCIE 4 x 8とレーン数が半分。

こちらのページがこの両GPUを比較したものです。4060の方が新しい機種というだけあって少し速い。

生成AIを実用したり、本格的に大規模なモデルを学習させたりするのではなく、生成AIを含めてAI(深層学習や機械学習)を理解するための学習や研究をするという目的に絞れば高価なGPUを購入する必要はなさそうです。どのみちOpenAIやGoogleなどの大企業が開発する生成AIのモデルを作るには大規模な計算資源を必要とするので、資金力の無い個人や小さな企業が取り組むのは無理です。本格的な研究開発をするにはそれ相応の機関に入ることとして、そこに至るまでの学習や研究には安価PCを組めば良いということになります。

LLMの学習をやっていてもう一点わかったのは、CPUの使用率がとても高い点です。ほぼすべてのコアの使用率が非常に高くなります。

これらを総合すると、小さなモデルを開発する、学習させる、動かして遊んでみる、という前提ならば、

- 高価なGPUは不要(RTX3060や4060で十分)

- CPUはなるべくコア数の多いものが良い

- GPUのPCIEインターフェースは特別高速なものでなくても良い

ということになります。

大きなGPUを使わないのであれば、高出力の電源は必要ありませんし、PCIEのインターフェースも4×16ではなくて3×16でも良さそうですから、安価なマザーボードや電源を使ってPCを組めることになります。

そういう視点でPCを自作すれば、かなり安く上げられますし、学生のためにAI開発の勉強をする環境を用意することもできます。AI技術を学ぶことは身近なものになると思います。

例えば、CPUはRyzen 7 5700(8コア16スレッド)、GPUはRTX 3060程度、マザーボードはA520チップセット搭載のもの、電源は600W程度、SSDはGen 3の1TB程度、RAMは16GBから32GBのDDR4、みたいな1世代〜2世代前の構成でも十分にAIの勉強ができるということになります。試しにこのような構成でAMAZONで部品を選んでみたところ、約10万円でした。(キーボード、マウス、モニター別です)

モノづくり塾では、自作PCワークショップもやっており、用途に合わせた部品の構成の提案もしています。予算に余裕はないけれど、新しい技術に触れたい・学びたいという方を応援します。