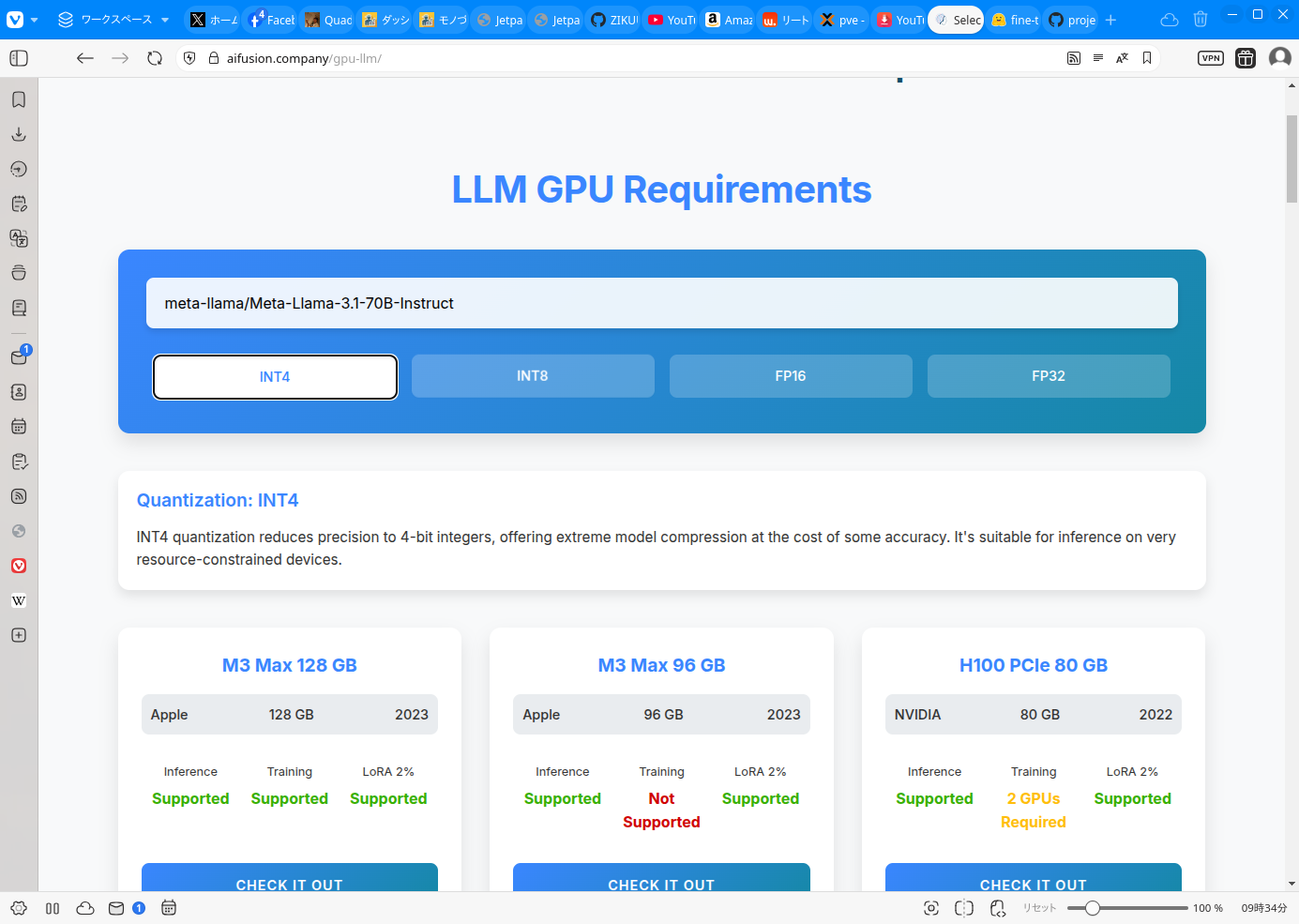

このサイトを見ればLLMのパラメーターに対して必要なGPUのVRAMの容量がわかります。

いずれモノづくり塾でも70B (700億)パラメーター程度のオープンソース(またはオープンウェイト)のLLMを実用したいと思っていますが、INT4やINT8にクオンタイズ(量子化)したモデルを使うにしても80GB以上のVRAMが必要です。なかなかハードルが高いですが、NVIDIAやASUSが発表しているGPUミニPCを使うなどすれば、うちのような弱小組織でもなんとか実現しそうです。

LLMをスクラッチから作る、フルパラメーターチューニングするといったことをするためには、巨大なGPUサーバーが必要でなかなか難しいですが、LLMを作ることを学ぶだけなら小さなモデルで勉強すれば良いし、70BくらいのモデルならLoRAなどの部分的なパラメーターチューニングができれば、RAGを併用するなどして実用的なアプリケーションを育てることができるはずですので、当面の目標としては80GB以上のGPUサーバーを手に入れるということになります。

AI開発者というのは、LLMなどのモデルを作る者です。その場合は、より良いモデルを作るための手法研究を含みます。新しい仕組みを考えるとか。

その一歩後ろで、既存のモデルを改善する、既存のモデルを上手く使うという者は、従来の言い方ならばアプリケーション開発者ということになります。

提供されたものを使うだけなら消費者ですかね。

私としては、自分の実力や状況を考えると、アプリケーション開発者止まりかなと思っています。AI開発者の領域は少し遠い感じがします。勉強はしますが先端を走る力はなさそうです。

モノづくり塾では、まずは全員にAIを使う消費者になってもらって、プログラミングができる人にはアプリケーション開発者になってもらう。その過程で好奇心や探究心がある人は、その先に進んでもらう。そんな風にできればと思っています。

私が生きている間は、塾の売上はすべて設備投資に回すつもりでいます。