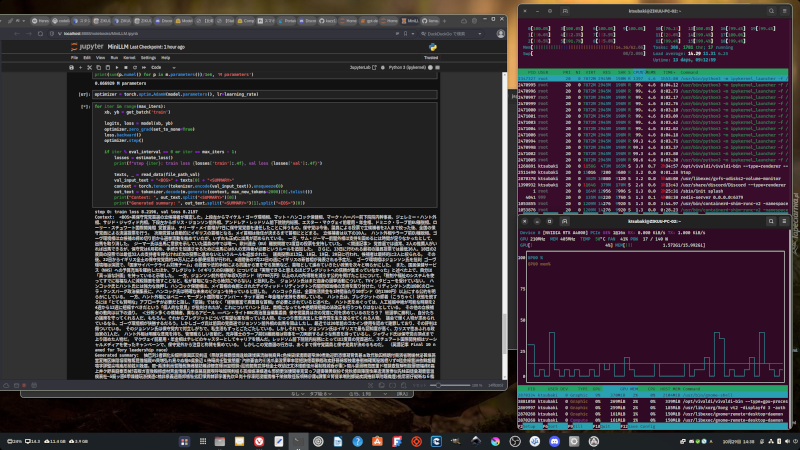

小規模なトランスフォーマーを使った言語モデルを作って遊んで(勉強して)います。

学習を重ねる過程で少しずつ賢くなっていくのを見ているのが面白い。

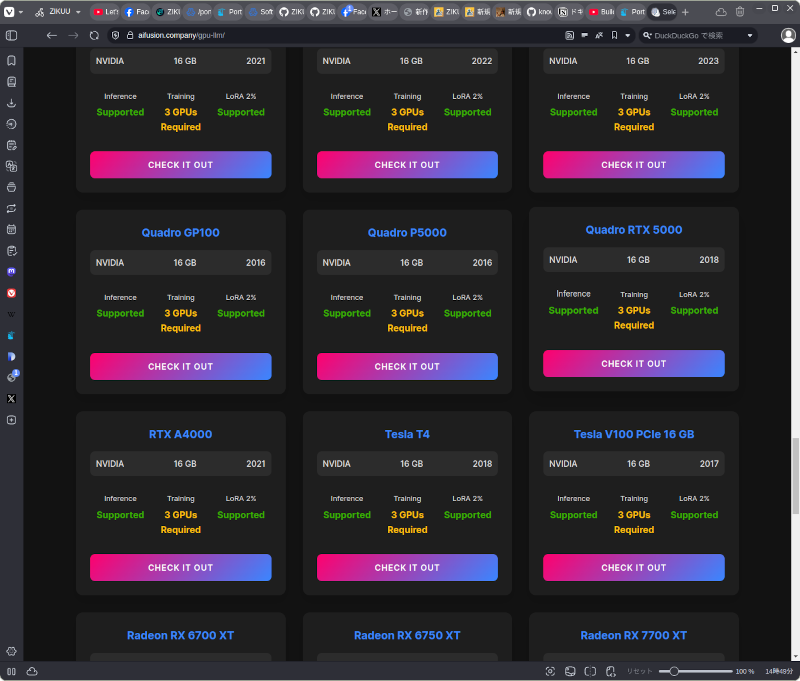

ローカルでLLMを学習させるのに必要なGPUメモリーがこのページに載っています。

作業中のPCにはRTX A4000というGPUが搭載されていますが、Gemma 2の2Bのモデルでも、フルパラメーターの学習をするのに、同GPUが3枚必要と出ています。

70BくらいのモデルになるとGPUのVRAMは1TBほど必要になるようで、とても個人や資金力のない会社では手が出せません。

モノづくり塾のような弱小組織では大きな言語モデルを扱うのは無理ですが、「どういう仕組みになっているか」、「どうやって作るか」、「どうすれば有効に活用できるか」みたいなことは学べるようにします。