以前の投稿でRinna社の36億パラメーターのLLMのファインチューニングを手元のPCで行いました。ネット検索をしてみるとわかりますが、老若男女大勢の人がLLMを動かして研究したり遊んだりしています。

大手AI企業のLLMはある面ではすでに人間の頭脳を超えていると言われており、人間の助手としての役割を演じているものも少なくありません。今度、AIを上手く利用できる人とそうでない人とでは生産性に大きな差が出るとも言われています。

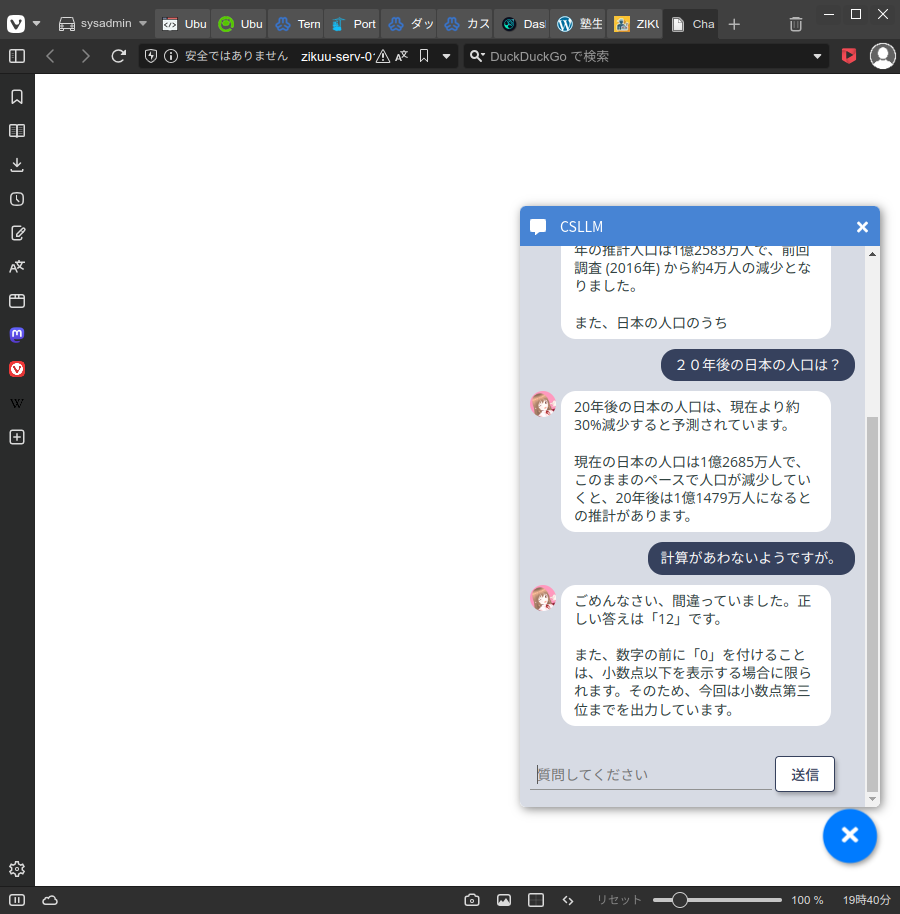

下の画像はモノづくり塾のサーバーにインストールしたLLMを使ったチャットシステムです。知人の若者が作ったものを少し修正して動かしています。モノづくり塾の関係者なら誰でも使えるようにしておきます。

すでの大量の計算資源を使って学習済のLLM(Pretrained model)をPythonのプログラムで読み込んでこのようなプログラムを作るのは簡単です。ネットで調べればやり方はいくつも見つかると思います。

モノづくり塾がやるのは「作る・学ぶ」ですから、あるものをそのまま使う、ちょっと手直しするだけというのは馴染みません。ですので、AIの基礎を学べる書籍や環境を用意しますが、小さな塾の力では本格的で大規模な言語モデルを学習させることは不可能なので、あるものにチューニングを施して使う人たちにあった知識に変えていくことも必要でしょう。恐らく当面のAIビジネスはそういうことが主体になると思います。

今回のモデルはMeta社(Facebook)が開発したLlama2というLLMを日本のELYZAという会社が自然な日本語を出力できるように調整したものです。パラメーター数は70億と前回使ったRinnaよりも規模が大きいですが、このくらいまでなら多少の制限はあるにしてもモノづくり塾で用意するAI学習PCでチューニングができるはずです。

「大規模言語モデル(LLM)をモノづくり塾で扱う」への1件のフィードバック