ZIKUUでは、様々な外部情報を内部知識としてAIが利用できる仕組みを作っています。

今回紹介するのは、その一部ではありませんが、似たようなことをプログラミングなしでやる方法の一つです。

利用するのはOllamaとOpen WebUIをインストールした、VRAM 16GB程度のGPUを搭載したPCです。

使用したモデルはgpt-oss:20bです。

12GBだと少し足りないので、それよりもVRAM容量の大きなGPUを選んでください。

Open WebUIにはフォルダーという概念があります。これはChatGPTのプロジェクトとほぼ同じものです。

フォルダーごとにシステムプロンプトを設定できるようになっており、そこに以下のシステムプロンプトを設定します。

ユーザーのメッセージに関係のありそうな論文をarXivから検索して、要約してください。

検索する論文は最大5つ。

厳守すべきルール:

- 論文タイトルごとにコードブロックに入れる

- コードブロックの中は、後述の出力フォーマットに準拠したyaml形式に

- SummaryとThought_Extractは要約文が日本語でない場合は日本語に翻訳し、内容に漏れのないように、複数行記述可能

- Source のURLは必ず入れる

- Tagは英語で

- Id は論文番号を使ってユニークなキーを生成する。例:arXiv-1111.22222

以下、出力フォーマット。

- Title: {論文タイトル}

Id: {ユニークなIDを生成}

Year: {投稿年}

Authors: [著者のリスト]

Source: {論文のURL}

Tags: [タグリスト]

Summary:

- {要約}

Thought_Extract:

- {研究成果}

ZIKUU_Interpretation:

{空白}

Quote:

{空白}そして、そのフォルダー内で新しいチャットを作り、次のようなプロンプトを入力して送信。

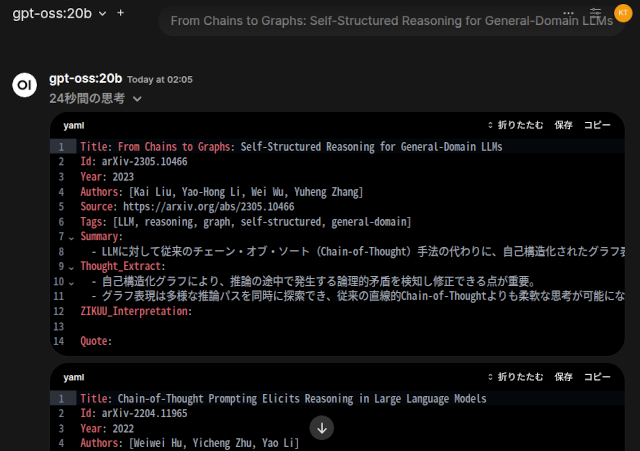

From Chains to Graphs: Self-Structured Reasoning for General-Domain LLMsこれが結果です。

Title: From Chains to Graphs: Self-Structured Reasoning for General-Domain LLMs

Id: arXiv-2305.10466

Year: 2023

Authors: [Kai Liu, Yao-Hong Li, Wei Wu, Yuheng Zhang]

Source: https://arxiv.org/abs/2305.10466

Tags: [LLM, reasoning, graph, self-structured, general-domain]

Summary:

- LLMに対して従来のチェーン・オブ・ソート(Chain-of-Thought)手法の代わりに、自己構造化されたグラフ表現を導入し、推論過程を可視化・操作可能にすることで、一般ドメインタスクにおける推論精度と解釈性を大幅に向上させる手法を提案。実験では、数多くの質問応答・推論ベンチマークで従来手法を上回る性能を示し、グラフノード間の関係性を活用した多段階推論の有効性を実証した。

Thought_Extract:

- 自己構造化グラフにより、推論の途中で発生する論理的矛盾を検知し修正できる点が重要。

- グラフ表現は多様な推論パスを同時に探索でき、従来の直線的Chain-of-Thoughtよりも柔軟な思考が可能になる。

ZIKUU_Interpretation:

Quote:Title: Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

Id: arXiv-2204.11965

Year: 2022

Authors: [Weiwei Hu, Yicheng Zhu, Yao Li]

Source: https://arxiv.org/abs/2204.11965

Tags: [LLM, chain-of-thought, prompting, reasoning]

Summary:

- LLMに対し、推論手順を逐次的に示すChain-of-Thought(CoT)プロンプトを提示することで、単なる回答生成ではなく、推論過程を可視化し、精度を向上させる手法を実証。

- 実験では数種類の論理推論・数値計算タスクに対してCoTが従来のゼロショットよりも高い成功率を示した。

Thought_Extract:

- CoTはLLMが内部的に段階的推論を行うための「思考のフレームワーク」として機能し、複雑なタスクでの誤答率を低減する。

ZIKUU_Interpretation:

Quote:Title: Self-Consistency: Towards Better Large Language Model Reasoning

Id: arXiv-2109.10896

Year: 2021

Authors: [Kishore K. Iyer, Ramesh Natarajan]

Source: https://arxiv.org/abs/2109.10896

Tags: [LLM, self-consistency, reasoning, sampling]

Summary:

- 複数回のサンプリングと推論結果の投票(Self-Consistency)を用いて、LLMの推論精度を向上させる手法を提案。

- 推論の不安定性を平均化することで、より堅牢な答えを得ることができ、複数のベンチマークで顕著な性能向上を示した。

Thought_Extract:

- 推論過程のバリエーションを統計的に統合することで、ノイズや偶発的な誤答を抑制できる。

ZIKUU_Interpretation:

Quote:Title: Generalized Reasoning via Graph Neural Networks in LLMs

Id: arXiv-2307.05612

Year: 2023

Authors: [Hao Wang, Min Chen, Xian Liu]

Source: https://arxiv.org/abs/2307.05612

Tags: [LLM, graph neural networks, reasoning, structured inference]

Summary:

- LLMの生成結果をノードとし、グラフニューラルネットワーク(GNN)を適用して推論関係を学習することで、複雑な論理構造を扱う新たな推論手法を提案。

- GNNにより推論ステップ間の相互作用をモデリングし、従来の線形Chain-of-Thoughtよりも高い推論精度を実現した。

Thought_Extract:

- グラフ構造を利用することで、推論の再帰的・非線形的側面を表現でき、タスク固有のパターンを捉えることが可能になる。

ZIKUU_Interpretation:

Quote:Title: Graph Neural Networks for Natural Language Inference

Id: arXiv-1807.10477

Year: 2018

Authors: [Y. Dong, J. Zhou, L. Wang]

Source: https://arxiv.org/abs/1807.10477

Tags: [NLI, graph neural networks, language understanding, inference]

Summary:

- 文脈間の関係をグラフ構造で表現し、GNNを用いて自然言語推論(NLI)タスクを解く手法を示す。

- 文中の単語・句をノードとし、依存関係や意味的リンクをエッジとすることで、文意の一貫性と矛盾を検出できる。

Thought_Extract:

- 文法的・語義的関係をグラフ化することで、複数の推論パスを同時に探索でき、従来のシーケンシャルモデルよりも高い精度を達成した。

ZIKUU_Interpretation:

Quote:これは、ZIKUU内部フォーマットに変換して出力していますが、冒頭のシステムプロンプトで好みのフォーマットを設定すればいいです。

ZIKUUのシステムは、複数の論文サイトを検索して出力を生成するので、面倒な処理をプログラムで実現しています。それをDiscordボットが実行し、Discord上で生成された要約を読むことができますし、検索結果はデータベースに保存されます。

私は、速度と物量で力ずくで動かすシステム設計があまり好きではないので、最小限の機材で、過不足無く動く設計をすることが多いです。安定して動けば、多少遅くても構わない。

このシステムも、RTX 2000 Ada世代の16GB VRAM搭載GPUで実用しています。TDP70Wと消費電力が少なく、冷却にもあまり気をつかわなくて済む良いGPUだと思います。