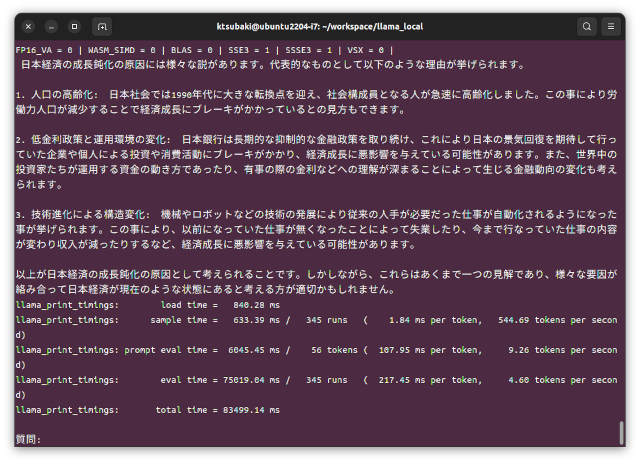

LlamaCppを使いGPUを使わずにCPUだけで大規模言語モデルを扱う例を文書化しモノづくり塾の資料館に保存しました。

実行している様子です。

ELYZAの70億パラメーターのものを量子化して軽くしたモデルを使った例です。

今となっては遅いPCである第6世代Core i5程度のノートPCでもなんとか実用的な速度が出ます。

ChatGPTのような大きなものではありませんが、日本語を学習した言語モデルがいくつか公開されており、使い方によっては面白いアプリケーションを作れるかもしれません。

LlamaCppを使いGPUを使わずにCPUだけで大規模言語モデルを扱う例を文書化しモノづくり塾の資料館に保存しました。

実行している様子です。

ELYZAの70億パラメーターのものを量子化して軽くしたモデルを使った例です。

今となっては遅いPCである第6世代Core i5程度のノートPCでもなんとか実用的な速度が出ます。

ChatGPTのような大きなものではありませんが、日本語を学習した言語モデルがいくつか公開されており、使い方によっては面白いアプリケーションを作れるかもしれません。