CTransformersとGradioを使ったCode Llamaを動かすアプリケーションをDocker対応しました。モノづくり塾のサーバーで動かしています。

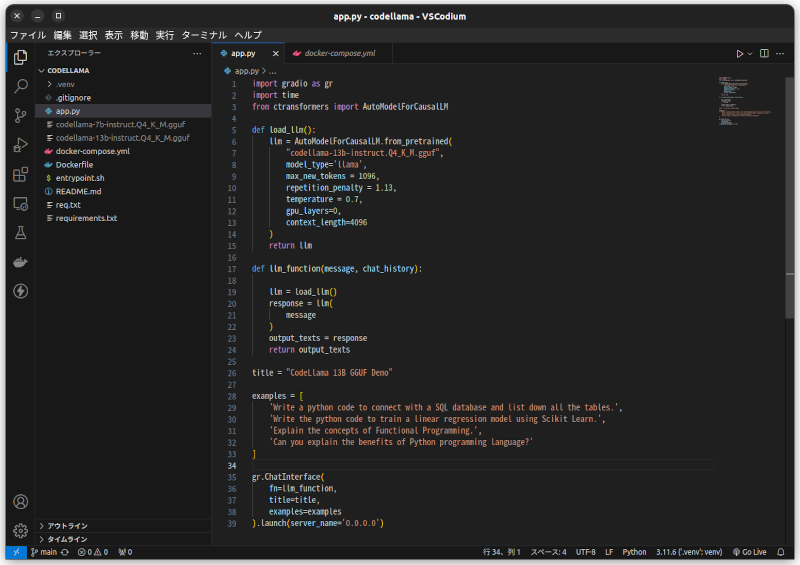

プログラムはこんなに短くて簡単。

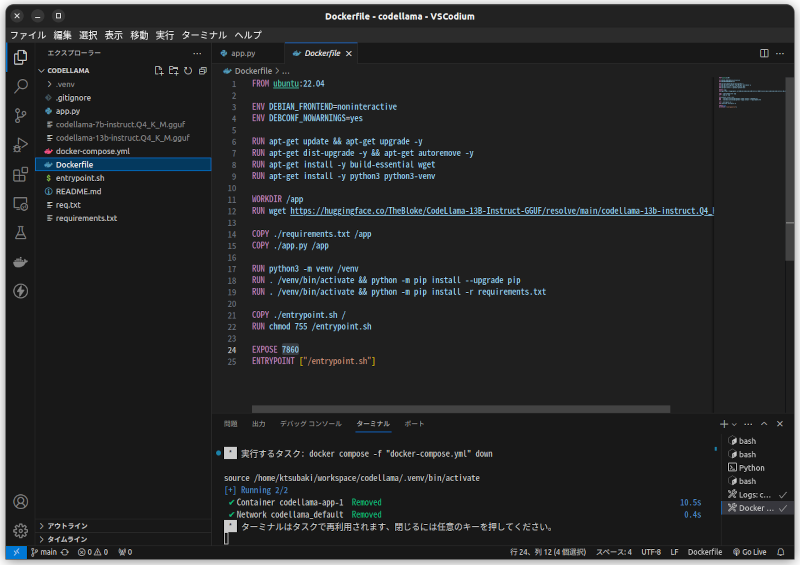

Dockerfileはこれ。

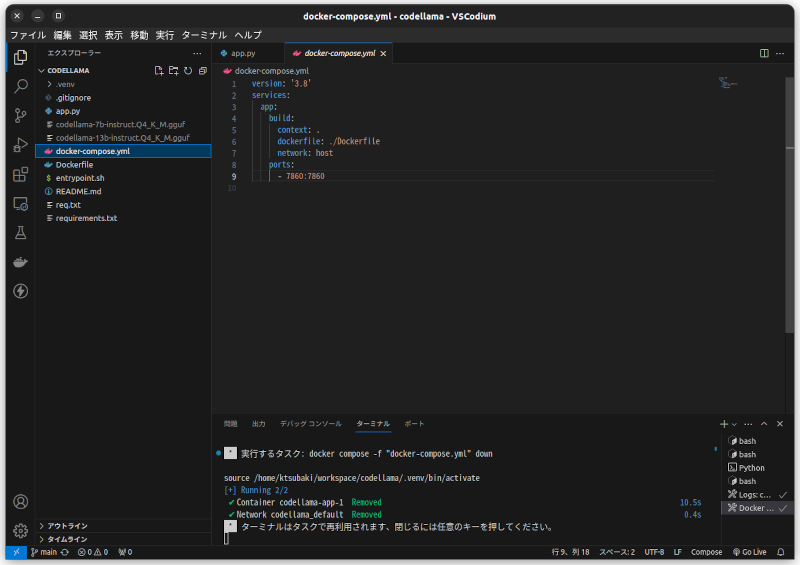

docker composeファイルはこれ。

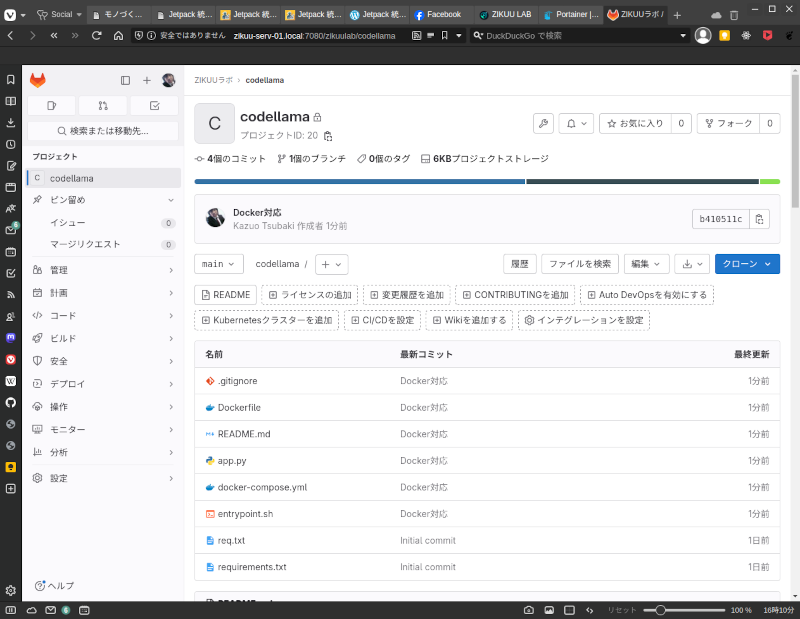

モノづくり塾ではサーバーにアプリケーションをデプロイするために次の手順を踏みます。現時点ではこれが標準的なやり方です。

1.このプロジェクトを塾サーバーのGitLabにプッシュ。

2.サーバーにログインしてプロジェクトをクローンして docker compose up -d を実行。大きなモデルファイルをダウンロードするのでDockerイメージが作られるまでに時間がかかります。

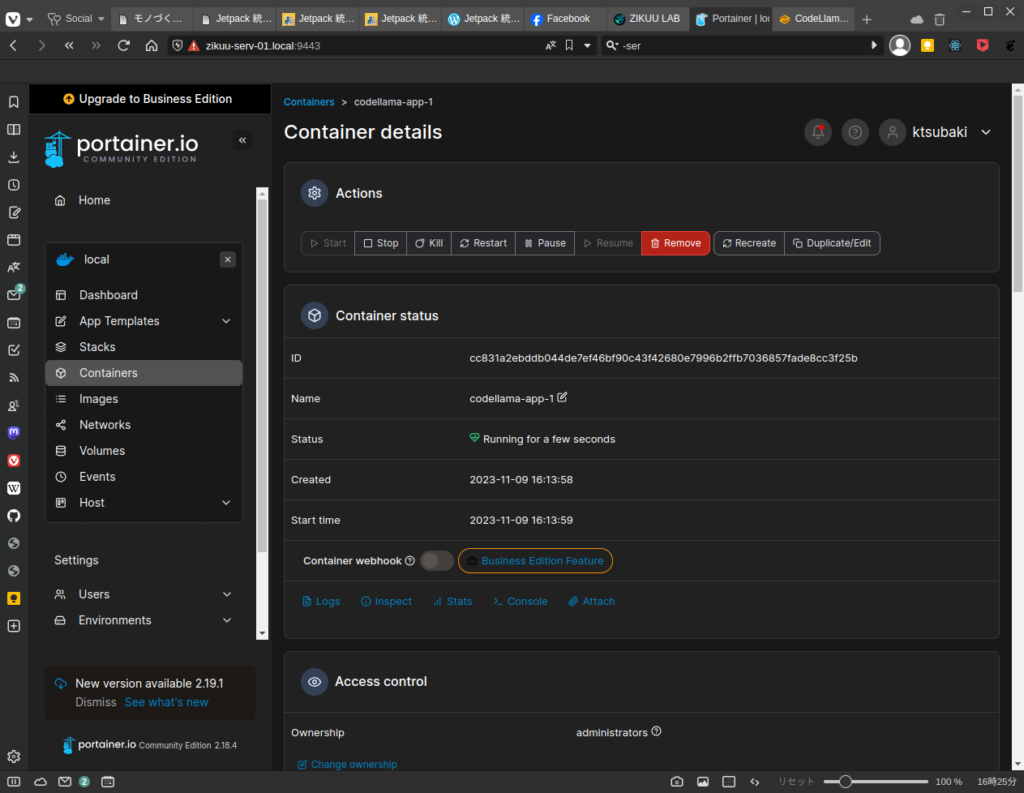

3.コンテナが起動したのをPortainerで見ているところです。

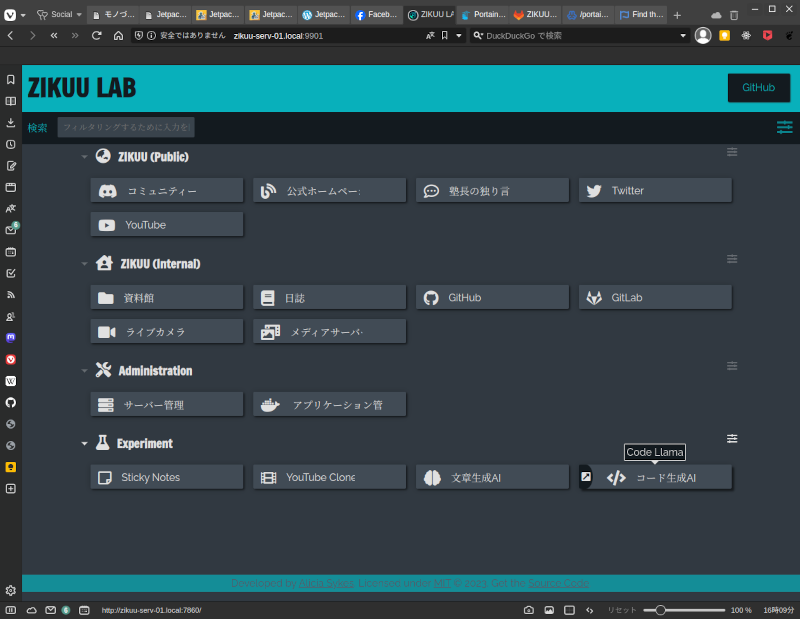

4.Dashyのダッシュボードにアプリケーションを登録します。

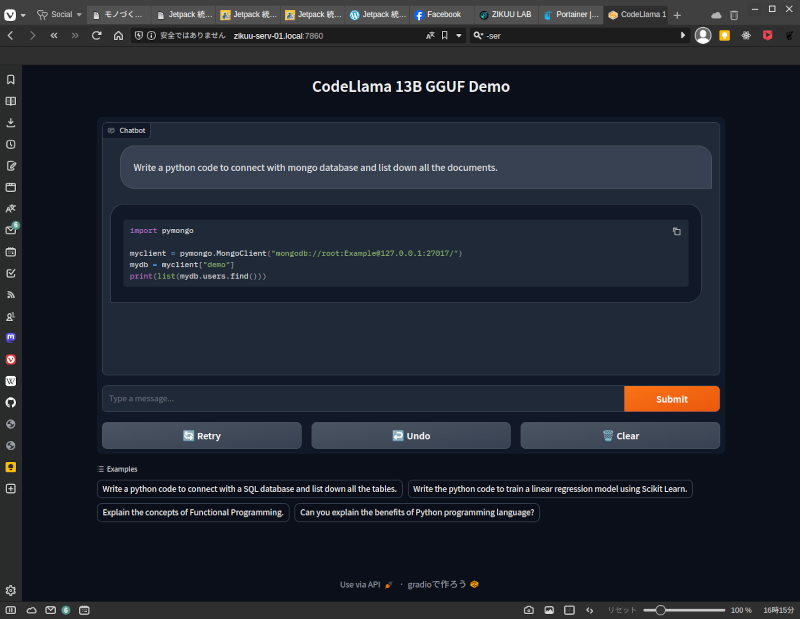

5.アプリケーションを選んで起動するとGradioで作ったWeb UIが開きます。

だいたいこんな流れです。コマンドを入力するのは2の部分だけです。

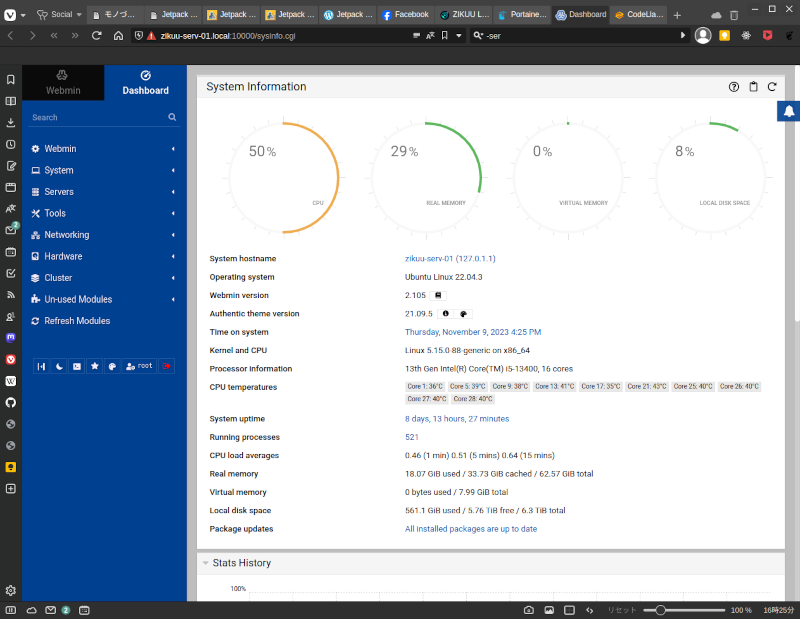

コード生成中のサーバーの様子です。CPU使用率が52%くらいまで上がります。

これでも昔に比べれば開発から運用までの工程が速く楽になっていますが、最終的にはGItLabにプッシュしたら自動的にサーバーにデプロイされるようにしなくてはいけません。